दक्षिण कोरिया में हाल ही में हुई "रूम एन 2.0" घटना ने एक बार फिर डीपफेक के सामान्य विषय को सामने ला दिया है।

अपराधी टेलीग्राम पर एकत्र हुए और महिला तस्वीरों को नग्न तस्वीरों में संश्लेषित करने के लिए एआई का इस्तेमाल किया, जिससे पता चलता है कि मनोरंजन सितारों और राजनेताओं से लेकर आपके और मेरे जैसे आम लोगों तक डीपफेक का दायरा पहले ही फैल चुका है।

इस युग में जब एआई एक प्रमुख विज्ञान बन गया है, हम यह समझना चाहते हैं कि यह तकनीक, जो नई नहीं लगती लेकिन हाल के वर्षों में तेजी से लोकप्रिय हो गई है, दैनिक जीवन को कैसे प्रभावित करती है।

डीपफेक किस हद तक विकसित हुए हैं और वे क्या नुकसान पहुंचाएंगे? डीपफेक से लड़ने के लिए प्रौद्योगिकी का उपयोग कैसे करें? आम लोग डीपफेक को कैसे रोकते हैं?

हमने इन मुद्दों पर रुइलाई इंटेलिजेंट एल्गोरिथम के वैज्ञानिक डॉ. चेन पेंग से बात की। रुइलाई विजडम की स्थापना 2018 में हुई थी और इसे सिंघुआ विश्वविद्यालय के आर्टिफिशियल इंटेलिजेंस रिसर्च इंस्टीट्यूट द्वारा इनक्यूबेट किया गया था। यह कई वर्षों से एआई नकली पहचान में गहराई से शामिल है।

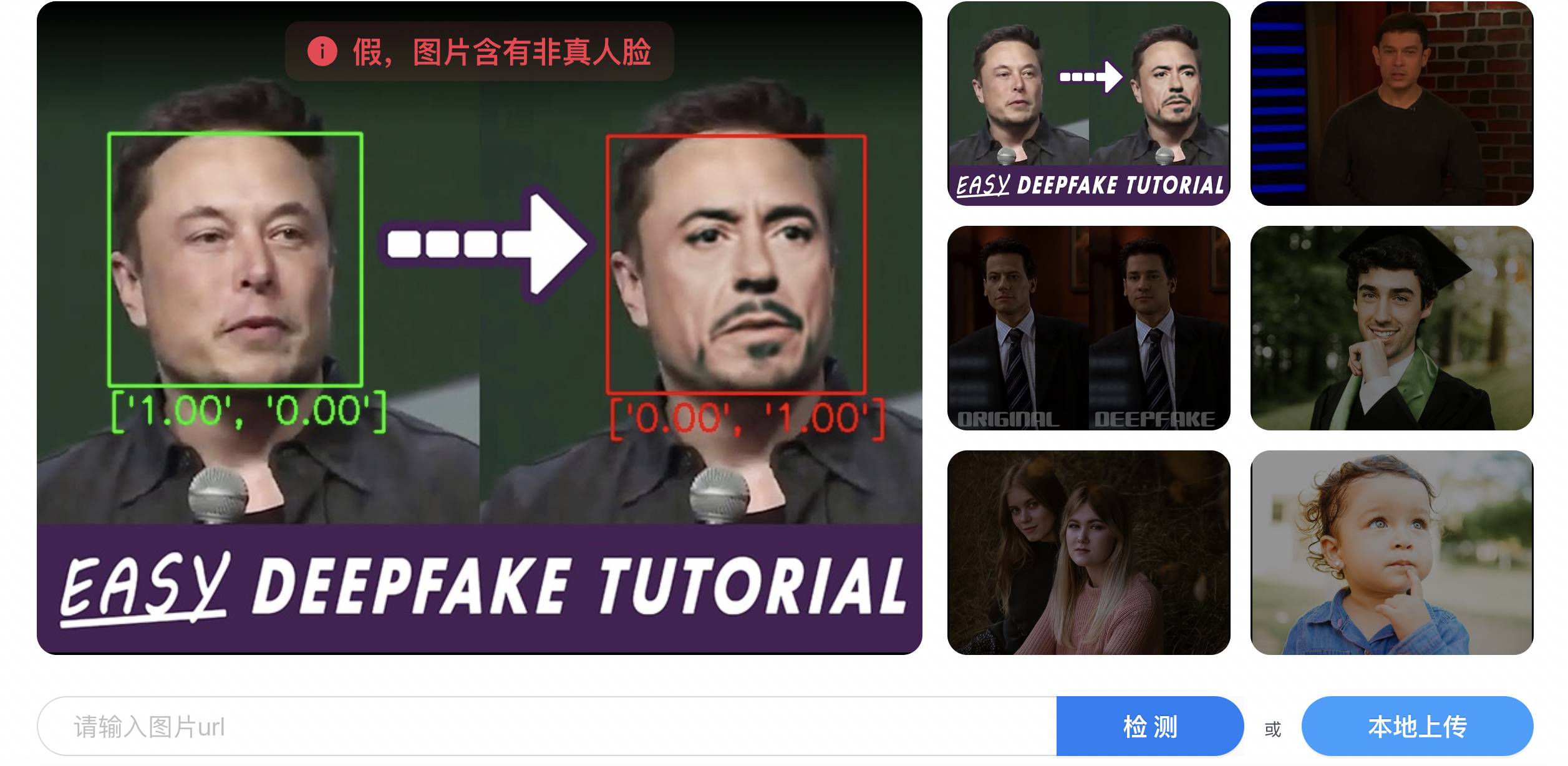

चेन पेंग ने हमें बताया कि आम लोग डीपफेक की पहचान करने में बुरी तरह विफल रहे हैं, और डीपफेक विरोधी अभी भी एआई पर निर्भर है।

एक तस्वीर, कुछ सेकंड, डीपफेक आसान और आसान होता जा रहा है

डीपफेक पहली बार 2017 में रेडिट पर उभरा, "टाइबा का अमेरिकी संस्करण"। इसका मुख्य रूप मशहूर हस्तियों के चेहरों को अश्लील वीडियो के नायकों से बदलना, या राजनीतिक हस्तियों को धोखा देना है।

आज, अफवाहें फैलाना और अश्लील साहित्य में संलग्न होना अभी भी डीपफेक का मुख्य उपयोग है, लेकिन वे अब आसान हो गए हैं।

चेन पेंग ने बताया कि चेहरा बदलने के लिए एक तस्वीर एकत्र करना पर्याप्त है, बेशक, जितना अधिक डेटा एकत्र किया जाएगा, चेहरे का विवरण जैसे कि तिल और चेहरे की विशेषताएं बेहतर ढंग से तैयार की जाएंगी, और चेहरा बदलने का प्रभाव उतना ही अधिक यथार्थवादी होगा। .

इसी साल अप्रैल में दो जर्मन कलाकारों का प्रदर्शन कला प्रोजेक्ट इसका जीता जागता उदाहरण है.

उन्होंने एक एआई कैमरा एनयूसीए डिजाइन किया है। कैमरा बॉडी 3डी प्रिंटेड है और इसमें एक बिल्ट-इन 37 मिमी वाइड-एंगल लेंस है। ली गई तस्वीरें क्लाउड पर प्रसारित की जाएंगी, जहां एआई "कपड़े उतार देगा" और फोटो खींची जाएगी 10 सेकंड से भी कम समय में "बाहर निकाला जाएगा"।

NUCA वास्तव में यह नहीं जानता कि आपका नग्न शरीर कैसा दिखता है। यह केवल आपके नग्न शरीर को AI की नजरों में प्रस्तुत करने के लिए आपके लिंग, चेहरे, उम्र, शरीर के आकार आदि का विश्लेषण करता है।

किसी न किसी? शायद इससे कोई फर्क नहीं पड़ता, कुछ ही सेकंड में, आप एआई के संपर्क में आ जाएंगे, और दूसरों को विश्वास हो सकता है कि यह आप ही हैं।

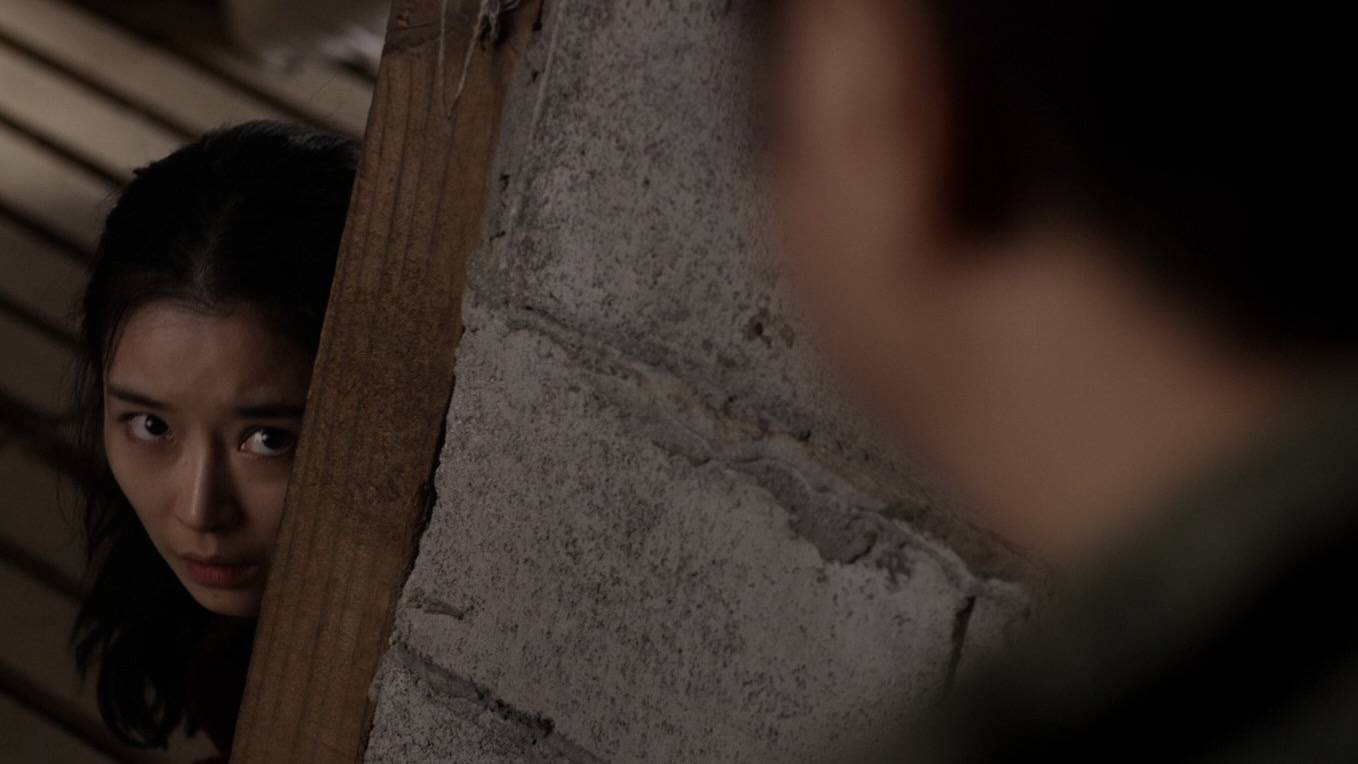

दक्षिण कोरिया के "रूम एन 2.0" को भी इसी तरह के विवरण के साथ उजागर किया गया है: 227,000 लोगों के साथ एक टेलीग्राम चैट रूम, एक अंतर्निर्मित रोबोट जो महिला तस्वीरों को नग्न तस्वीरों में संश्लेषित करता है और स्तनों को समायोजित कर सकता है, और 5 से 7 सेकंड में डीपफेक सामग्री तैयार करता है।

चैट रूम का स्क्रीनशॉट, जिसमें डीपफेक का उपयोग करने का तरीका बताया गया है

चेहरे बदलना और कपड़े उतारना डीपफेक का सिर्फ एक अनुप्रयोग है।

टेक्स्ट, इमेज, ऑडियो और वीडियो सहित यथार्थवादी सामग्री को संश्लेषित करने या बनाने के लिए जेनरेटिव एआई मॉडल (जीएएन, वीएई, डिफ्यूजन मॉडल इत्यादि) का उपयोग करना डीपफेक कहा जा सकता है।

इनमें ऑडियो डीपफेक भी काफी आम है.

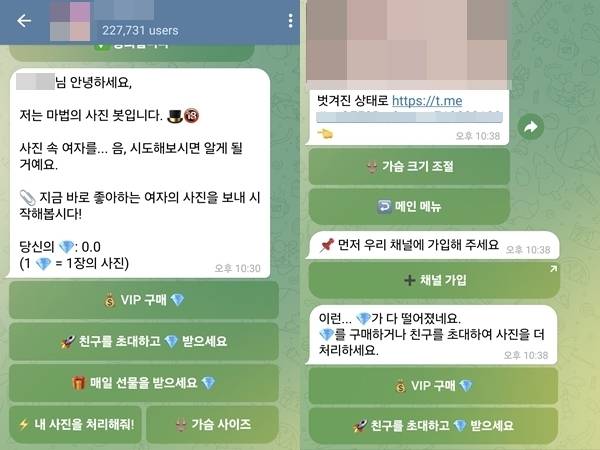

2023 की शुरुआत में, प्रौद्योगिकी रिपोर्टर जोसेफ कॉक्स ने बैंक की स्वचालित सेवा हॉटलाइन को कॉल किया, एआई वॉयस "माई वॉइस इज माई पासवर्ड" चलाया, जिसे उन्होंने इलेवनलैब्स के साथ क्लोन किया, और शेष राशि की जांच करने के लिए कहा, अप्रत्याशित रूप से, वॉयस सत्यापन सफल रहा।

चेन पेंग ने कहा कि यह आश्चर्य की बात नहीं है कि पहले हमारी वॉयसप्रिंट जानकारी को कैप्चर करने में कई मिनट या दर्जनों मिनट लगते थे, लेकिन अब इसे लगभग आधे मिनट या दर्जनों सेकंड में कैप्चर किया जा सकता है। अगर हमें कुछ और परेशान करने वाली कॉलें आती हैं, तो हमारी आवाज़ें लीक हो सकती हैं।

बेशक, यदि आप अधिक सटीक रूप से क्लोन करना चाहते हैं और टोन और अन्य बोलने की शैलियों की नकल करना चाहते हैं, जैसे कि गुओ डीगैंग को अंग्रेजी क्रॉस टॉक बोलने देना या स्विफ्ट को चीनी बोलने देना, तो भी आपको अधिक कॉर्पस की आवश्यकता है।

यहां तक कि पाठ भी एक ऐसा क्षेत्र है जो गहराई से नकली है। एआई-जनित पाठ लंबे समय से हर जगह देखा जा रहा है, और यह शिक्षकों के लिए सिरदर्द पैदा कर रहा है जब छात्र इसका उपयोग नकल करने और होमवर्क से निपटने के लिए करते हैं, लेकिन हम इसके पीछे के जोखिमों से अवगत नहीं हो सकते हैं।

झूठी खबरें और अफवाहें टेक्स्ट डीपफेक के सबसे कठिन हिट क्षेत्र हैं, चेन पेंग ने कहा कि अतीत में, मनुष्यों को अभी भी कॉपी खुद लिखने की जरूरत थी, लेकिन अब, एआई एक निश्चित घटना के बारे में विभिन्न टिप्पणियां उत्पन्न कर सकता है और फिर स्वचालित रूप से उन्हें सोशल मीडिया पर पोस्ट कर सकता है। .

चेन पेंग के अनुसार डीपफेक तेज़ और सरल है, इसके तीन मुख्य कारण हैं।

सबसे पहले, विंसेंट पिक्चर्स और विंसेंट वीडियो जैसी जेनेरेटिव एआई प्रौद्योगिकियों में सफलताएं मिली हैं, दूसरा, कंप्यूटिंग शक्ति अधिक से अधिक लोकप्रिय हो गई है, और उपभोक्ता-ग्रेड ग्राफिक्स कार्ड पहले से ही जेनेरिक एआई मॉडल चला सकते हैं।

एक और बहुत महत्वपूर्ण बात यह है कि डीपफेक तकनीक को कम सीमा वाले विभिन्न उपकरणों में अनुकूलित किया गया है।

उदाहरण के तौर पर फेस-चेंजिंग को लें। डीपफेक के लिए कई ओपन सोर्स प्रोजेक्ट हैं, जैसे जीथब पर डीपफेसलाइव और डीप-लाइव-कैम। उपयोगकर्ता वेबसाइट से कोड डाउनलोड कर सकते हैं और स्थानीय रूप से चल रहे वातावरण को कॉन्फ़िगर कर सकते हैं।

डीप-लाइव-कैम का उपयोग करके एआई मस्क लाइव प्रसारण

यदि नौसिखिए जो तकनीक को नहीं समझते हैं, उन्हें अभी भी यह मुश्किल लगता है, तो ऐसे पेशेवर भी हैं जो चावल को सीधे अपने मुंह में डालते हैं, मॉडल को एनकैप्सुलेट करते हैं, और इसे खिलाड़ियों के लिए मुफ्त में डाउनलोड करने के लिए सरल और उपयोग में आसान सॉफ़्टवेयर में लिखते हैं, और स्वयं कुछ विज्ञापन शुल्क अर्जित करें, जिसमें स्ट्रिपिंग के लिए कई एक-क्लिक ऐप भी शामिल हैं।

जहां तक ऑडियो डीपफेक का सवाल है, पहले से ही परिपक्व व्यावसायिक कंपनियां हैं जो उपयोगकर्ताओं को एसडीके (डेवलपमेंट किट) या एपीआई (एप्लिकेशन प्रोग्रामिंग इंटरफ़ेस) के रूप में सेवाओं का आसानी से उपयोग करने की अनुमति देती हैं।

उपयोगकर्ताओं को प्रोग्राम को तैनात करने के लिए ग्राफिक्स कार्ड वाले डिवाइस की भी आवश्यकता नहीं है, बल्कि इसके बजाय वेबसाइट पर ऑडियो जैसी सामग्री अपलोड करें, परिणाम उत्पन्न होने की प्रतीक्षा करें और फिर उन्हें डाउनलोड करें।

इसलिए, जटिल तकनीकी सिद्धांत पर्दे के पीछे छिपे होते हैं, और जो उपयोगकर्ताओं के सामने होता है वह "आउट-ऑफ़-द-बॉक्स" इंटरफ़ेस होता है। यहां तक कि किशोर भी अपनी इच्छानुसार गलत जानकारी बना सकते हैं।

संक्षेप में, चेन पेंग का निष्कर्ष है:

डीपफेक उस बिंदु तक पहुंच गया है जहां आम लोग इसे आसानी से प्राप्त कर सकते हैं।

मानव नग्न आंखों से डीपफेक की पहचान करने में पूरी तरह से विफल हो सकता है

जब कोई तकनीक "आम लोगों के घरों में प्रवेश करती है," तो सबसे अधिक प्रभावित होने की संभावना सामान्य लोगों की होती है।

डीपफेक द्वारा बुराई करने के सबसे आम तरीकों में से एक है धोखाधड़ी।

इस साल की शुरुआत में, एक बहुराष्ट्रीय कंपनी की हांगकांग शाखा को AI के कारण 25 मिलियन अमेरिकी डॉलर का चूना लगाया गया था। पीड़ित ने एक वीडियो कॉन्फ्रेंस में भाग लिया, और अन्य धोखेबाज थे जो "एआई फेस-चेंजिंग" और "एआई वॉयस-चेंजिंग" से गुजर चुके थे।

▲ पुलिस ने प्रदर्शित किया कि बहु-व्यक्ति वीडियो कॉन्फ्रेंस को नकली बनाने के लिए डीपफेक का उपयोग कैसे किया जाता है

अब जब हालात यहां तक पहुंच गए हैं, तो हम अपनी सुरक्षा के लिए क्या कर सकते हैं?

यदि कोई आपको धोखा देने के लिए डीपफेक का उपयोग करता है, तो एआई की खामियों का फायदा उठाना एक तरीका है, लेकिन इसकी एक शेल्फ लाइफ है।

उदाहरण के लिए, एक वीडियो कॉल के दौरान, यदि हमें संदेह है कि दूसरे पक्ष का चेहरा एआई द्वारा बदल दिया गया है, तो हम दूसरे पक्ष को विशिष्ट कार्य करने के लिए मार्गदर्शन कर सकते हैं, जैसे कि उसके चेहरे के सामने अपना हाथ रखना और कुछ बार तेज़ी से स्वाइप करना, या अपना सिर काफ़ी घुमा रहा है।

यदि एआई फेस रिप्लेसमेंट के पीछे का मॉडल विशेष रूप से हाथ अवरोधन के लिए अनुकूलित नहीं है, तो यह उजागर हो जाएगा और चेहरा हाथ के पीछे दिखाई दे सकता है, या यह अचानक विकृत हो सकता है।

सिर घुमाने का सिद्धांत समान है यदि डेटा संग्रह चरण के दौरान, दूसरा पक्ष जानबूझकर 45 डिग्री से अधिक सिर मोड़ने वाली सामग्री एकत्र नहीं करता है, तो चेहरे का फिट अप्राकृतिक होगा।

लेकिन भविष्य में नंगी आंखों से दिखने वाली ऐसी खामियां धीरे-धीरे कम जरूर हो जाएंगी।

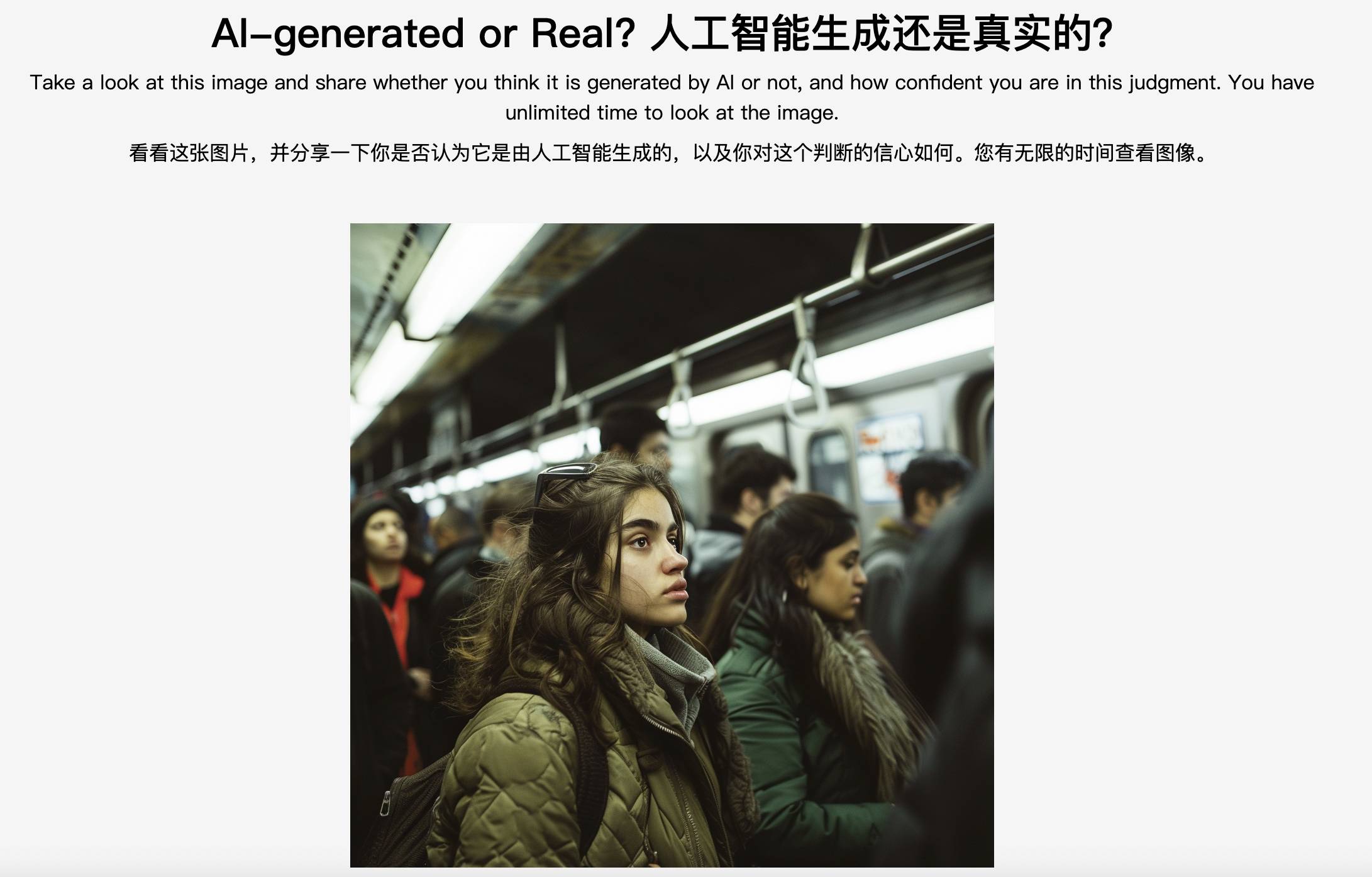

नॉर्थवेस्टर्न यूनिवर्सिटी का "समस्या निवारण" परीक्षण: एआई-जनित या वास्तविक?

चेन पेंग ने मजाक में कहा कि अगर धोखेबाज सोचते हैं कि आप एक मोटी भेड़ हैं जो वध होने का इंतजार कर रही हैं और जानबूझकर आपको धोखा देना चाहते हैं, आपकी सोशल मीडिया जानकारी छीन लेना चाहते हैं, और आपके मॉडल को अनुकूलित करने में कई दिन खर्च करना चाहते हैं, तो इन तरीकों के प्रभावी होने की गारंटी नहीं है।

यदि किसी वीडियो में ये खामियाँ नहीं हैं, तो क्या इसका मतलब यह है कि वह वास्तविक वीडियो है? ये सच नहीं है.

जहाँ तक यह प्रभावी है या नहीं, इसका सवाल है, यह निश्चित रूप से पूरी तरह से प्रभावी या 100% प्रभावी नहीं हो सकता है, लेकिन यह एक निश्चित सीमा तक प्रभावी है।

इसे अधिक पेशेवर शब्दों में कहें तो, मानव दृश्य धारणा शब्दार्थ स्तर पर बहुत अच्छा प्रदर्शन करती है, जैसे कि वस्तुओं या दृश्यों के अर्थ को आसानी से अलग करने में सक्षम होना, लेकिन जब पिक्सेल स्तर पर निम्न-स्तरीय बारीकियों को संसाधित करने की बात आती है, तो धारणा क्षमता AI मॉडल जितनी अच्छी नहीं है।

इस दृष्टिकोण से, चेन पेंग का मानना है कि आम लोग डीपफेक को अलग करने में बुरी तरह विफल रहे हैं। विशेषज्ञ अभी भी लड़ने में सक्षम हो सकते हैं, क्योंकि उन्होंने बहुत कुछ देखा है और उनके पास अपेक्षाकृत व्यापक विश्लेषण क्षमताएं हैं, और देख सकते हैं कि कुछ नियमों के अनुरूप नहीं है।

हममें से कोई भी लीउवेनहॉक नहीं है, न ही हमारी आँखें तेज़ हैं, लेकिन मानव स्वभाव अपरिवर्तित रहता है। इसलिए, हम पारंपरिक मनोवैज्ञानिक रक्षा रेखा को भी खींच सकते हैं जिसका प्रौद्योगिकी से कोई लेना-देना नहीं है – नौकायन करते समय सावधान रहें।

घोटाले अक्सर एक ही पैटर्न का अनुसरण करते हैं: गोपनीयता की चोरी करना, कहानियाँ बनाने के लिए भय, लालच और भावनात्मक मूल्य का उपयोग करना, परिचित होने का दिखावा करना या विश्वास हासिल करने के लिए खुद को पैकेजिंग करना, और अंतिम लक्ष्य पैसा है।

▲Realai Smart का उत्पाद RealBelieve वीडियो कॉल के दौरान प्रारंभिक चेतावनी जारी करेगा।

इसे ध्यान में रखें, और फिर अधिक सतर्क रहें। अपरिचित लिंक पर क्लिक न करें, सत्यापन कोड लापरवाही से न दें, अपने चेहरे, आवाज, उंगलियों के निशान और अन्य व्यक्तिगत बायोमेट्रिक जानकारी को इंटरनेट पर उजागर न करने का प्रयास करें, संदिग्ध फोन कॉल प्राप्त न करें। और जब पैसे की बात आती है तो एक-दूसरे की पहचान सत्यापित करने के तरीके अलग-अलग होते हैं, जैसे ऐसी चीजें पूछना जो केवल एक-दूसरे को पता हो।

जैसा कि पुरानी कहावत है, सबसे अच्छी बात यह है कि दिल पर हमला किया जाए। एक बार जब हमें एहसास हो जाए कि हमें धोखा दिया जा सकता है, तो हम धोखा नहीं खा सकते हैं।

जादू बनाम जादू, एआई ने एआई को हरा दिया

धोखाधड़ी विरोधी जागरूकता बढ़ाना पर्याप्त नहीं है। दक्षिण कोरिया की "रूम एन 2.0" घटना डीपफेक बुराई का एक और रूप दिखाती है। लोग घर पर बैठे हैं, और बर्तन स्वर्ग से आते हैं।

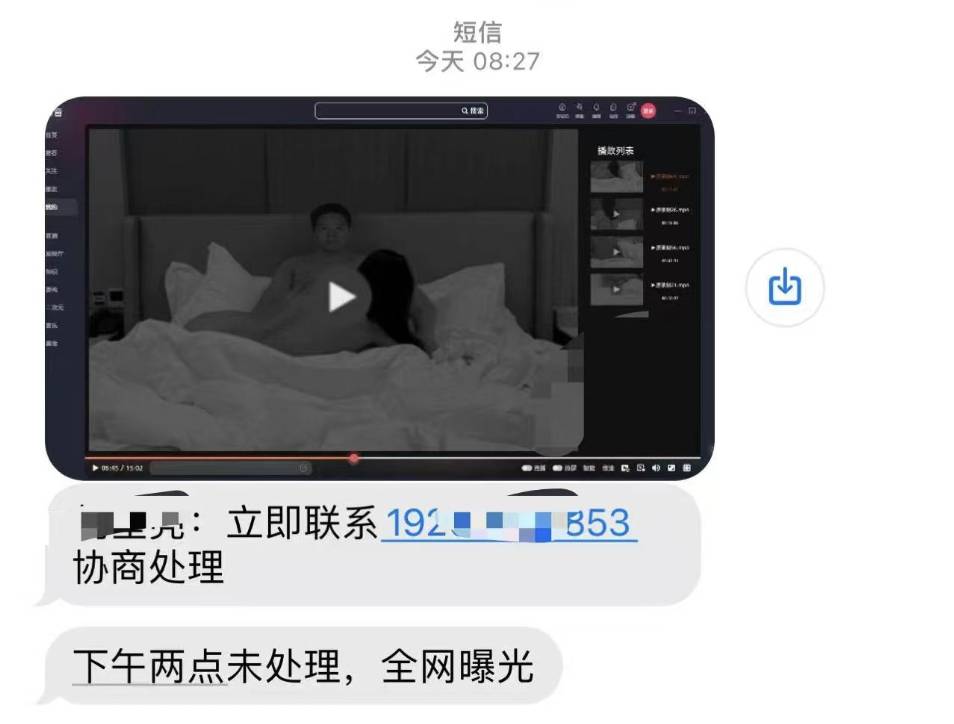

नकली नग्न तस्वीरों के पीड़ितों को "प्रतिशोधी अश्लील" का सामना करना पड़ सकता है – अपराधी पीड़ितों को ब्लैकमेल करने और परेशान करने के लिए डीपफेक सामग्री फैलाने की धमकी देते हैं, जिससे अधिक गंभीर माध्यमिक क्षति होती है।

लेकिन यह दरांती हमारे सिर पर भी उठाई जा सकती है: कल्पना करें कि धोखाधड़ी करने वाले गिरोह ने आपकी तस्वीरें कहीं से प्राप्त कर लीं, उन्हें अश्लील वीडियो में जोड़ दिया, आपको धमकी देने के लिए टेक्स्ट संदेश भेजे, और यदि आप पैसे ट्रांसफर नहीं करते हैं, तो यह उजागर हो जाएगा पूरे इंटरनेट पर आप खुद को कैसे साबित कर सकते हैं?

रुइलाई विजडम, जहां चेन पेंग काम करते हैं, ने वास्तव में इस तरह के व्यक्तिगत व्यवसाय का सामना किया है, दूसरे पक्ष ने कहा कि एक वीडियो में उनका चेहरा बदल दिया गया था, और क्या उन्हें साफ़ किया जा सकता है?

निःसंदेह इसके कई तरीके हैं: जादू बनाम जादू, एआई द्वारा एआई को पराजित करना।

चेन पेंग ने बताया कि एआई जालसाजी के लिए दो मुख्य तकनीकी मार्ग हैं: सक्रिय रक्षा और निष्क्रिय पहचान।

आइए पहले सक्रिय रक्षा के बारे में बात करें। जब हम सोशल मीडिया पर तस्वीरें पोस्ट करते हैं और नहीं चाहते कि उनका उपयोग अन्य लोग करें, तो हम उनमें कुछ दृश्यमान अदृश्य शोर शामिल कर सकते हैं।

यदि कोई अन्य व्यक्ति मॉडल को प्रशिक्षित करने के लिए हमारी तस्वीरों का उपयोग करता है, तो एआई इस अदृश्य हस्तक्षेप के कारण दृश्य प्रतिनिधित्व को अच्छी तरह से निकालने में सक्षम नहीं होगा, और अंतिम परिणाम विकृत या धुंधला हो सकता है। इसे "प्रतिकूल नमूना हमला" कहा जाता है। "

"अर्ध-असुरक्षित वॉटरमार्क" एक अन्य सक्रिय रक्षा पद्धति है। वॉटरमार्क जोड़ने के बाद अगर कोई और हमारी फोटो को एडिट करता है तो वॉटरमार्क नष्ट हो जाएगा और हमें पता चल जाएगा कि इमेज प्रोसेस हो चुकी है और भरोसेमंद नहीं है।

वॉटरमार्क सीधे तौर पर छवियों को डीपफेक होने से नहीं रोक सकते, लेकिन वे छवियों की प्रामाणिकता का पता लगा सकते हैं और प्रमाणित कर सकते हैं।

▲ विदेशों में भी इसी तरह की खोज की जा रही है। Adobe ने छवियों के स्रोत को निर्धारित करने के तरीके के रूप में मेटाडेटा मापदंडों का उपयोग करते हुए C2PA मानक की शुरुआत की।

बेशक, सक्रिय रक्षा की सीमा अधिक है, इसलिए हमें ऐसा होने से पहले सावधानी बरतने की ज़रूरत है और चित्रों पर पहले से कुछ प्रसंस्करण करना होगा।

एक अधिक सामान्य स्थिति यह है कि हमारे पास इसकी भविष्यवाणी करने का कोई तरीका नहीं है। हमें अपनी "नग्न तस्वीरें" प्राप्त होती हैं, लेकिन यह पहली बार होता है कि हम स्वयं के प्रति "स्पष्ट" होते हैं। इस समय, निष्क्रिय पहचान का उपयोग किया जाना चाहिए।

रीयलई इंटेलिजेंस के पास जालसाजी का पता लगाने के लिए जिम्मेदार एआई उत्पादों की एक श्रृंखला है, जिसमें जेनेरिक एआई कंटेंट डिटेक्शन प्लेटफॉर्म डीपरियल, फेस एआई सुरक्षा फ़ायरवॉल रीयलगार्ड इत्यादि शामिल हैं।

DeapReal

सीधे शब्दों में कहें तो, एआई की पहचान करने के लिए एआई का उपयोग दो चरणों में विभाजित है, सबसे पहले, बड़ी संख्या में जालसाजी सुविधाओं को निकालना, और फिर इन नमूनों के आधार पर एआई को जालसाजी की पहचान के नियम सीखने देना।

विकृत रंग, अनुचित बनावट, अप्राकृतिक अभिव्यक्ति, आउट-ऑफ-सिंक ऑडियो और वीडियो, अनियमित आईरिस आकार, और दो विद्यार्थियों की असंगत हाइलाइट्स एआई के लिए सीखने की सामग्री हैं।

उनमें से, वीडियो जालसाजी की सटीकता छवियों की तुलना में अधिक हो सकती है, क्योंकि वीडियो में निरंतर छवियों की एक श्रृंखला होती है, जो अधिक जानकारी प्रदान करती है जिसका उपयोग एकल छवि की तुलना में जालसाजी के लिए किया जा सकता है, जैसे कि विभिन्न छवियों के बीच एक चरित्र की उपस्थिति फ़्रेम. कार्रवाई की निरंतरता.

संक्षेप में, एआई जालसाजी कुछ हद तक दोष खोजने के लिए मानव आंखों का उपयोग करने जैसा है, और यह एआई मॉडल की खामियों का भी फायदा उठाता है।

▲ चाइनीज एकेडमी ऑफ साइंसेज के शोधकर्ताओं ने दुनिया के सामने डीपफेक का पता लगाने के लिए एआई मॉडल का खुलासा किया

लेकिन खामियां धीरे-धीरे निश्चित रूप से सुधर जाएंगी, इसलिए एक बहुत ही गंभीर सवाल उठता है: क्या पहले जालसाजी है और फिर प्रमाणीकरण? यदि हां, तो क्या जालसाजी हमेशा जालसाजी से आधा कदम पीछे नहीं होगी?

चेन पेंग ने उत्तर दिया कि उत्पन्न तकनीक जालसाजी तकनीक से थोड़ी आगे हो सकती है, लेकिन उनके पास डीपफेक के खिलाफ बचाव करते हुए डीपफेक का अनुकरण करने के लिए एक आंतरिक लाल-नीला हमला और रक्षा प्रयोगशाला है, और डीपफेक की पहचान क्षमताओं में लगातार सुधार होता है।

यदि कोई नई डीपफेक तकनीक सामने आती है, तो वे इसे तुरंत पुन: पेश कर सकते हैं और फिर इसे डिटेक्शन उत्पाद पर सत्यापित कर सकते हैं। "जब नई तकनीक सामने आती है, भले ही मैंने इसे नहीं देखा हो, फिर भी मैं कुछ हद तक इसका पता लगा सकता हूं।"

इसके अलावा, मॉडल में स्वयं भी एक निश्चित सामान्यीकरण क्षमता है, इसने बहुत सारी डीपफेक सामग्री देखी है और अगर इसका सामना अदृश्य सामग्री से होता है तो यह एक निश्चित सीमा तक इसकी सटीक पहचान और पता लगा सकता है।

▲ बिलिबिली जैसे प्लेटफ़ॉर्म एआई चेहरा बदलने वाली मनोरंजन सामग्री को लेबल करेंगे

संक्षेप में, एआई जालसाजी और जालसाजी का पता लगाना दीर्घकालिक टकराव और आपसी प्रतिस्पर्धा का "चूहे-बिल्ली का खेल" है।

यही कारण है कि चेन पेंग एआई जालसाजी एल्गोरिदम का अध्ययन कर रहे हैं:

एंटी-डीपफेक बहुत संघर्षपूर्ण है और इसके लिए दीर्घकालिक निवेश की आवश्यकता होती है, कई एआई उत्पादों के विपरीत, आप इसे खत्म करने के बाद इसके बारे में भूल सकते हैं।

इसके बावजूद, वह अभी भी अपेक्षाकृत आशावादी हैं: "पर्यवेक्षण के लिए कानूनों और विनियमों का उपयोग करें, प्लेटफ़ॉर्म सामग्री का प्रबंधन करें, उद्योग प्रौद्योगिकी और उपकरण प्रदान करता है, और मीडिया अधिक लोगों को जोखिमों के बारे में जागरूक करता है। यदि बहुआयामी शासन एक निश्चित स्तर तक पहुंचता है, तो ऐसा होगा निश्चित रूप से एक सहजता होगी।"

भविष्य में, इंटरनेट पर सर्फिंग करते समय, हम ऐसे कुछ हद तक बेतुके परिदृश्य में पड़ सकते हैं: सत्यापन कोड आपको यह साबित करने की अनुमति देता है कि "मैं एक इंसान हूं", और डीपफेक आपको यह साबित करने की अनुमति देता है कि "मैं मैं नहीं हूं"।

प्रौद्योगिकी सभी दुर्भावनापूर्ण इरादों का पूरी तरह से पता नहीं लगा सकती है, लेकिन मनुष्यों को बहुत अधिक चिंतित होने की आवश्यकता नहीं है, डीपफेक की सफलता केवल अंतिम परिणाम है, लेकिन डीपफेक को रोकना किसी भी समय शुरू हो सकता है।

जैसा कि चेन पेंग ने कहा, यहां तक कि एक बहुत ही सरल एआई उत्पाद भी एक बहुत ही व्यवस्थित परियोजना है।

हम एक बड़ी व्यवस्था का हिस्सा हैं। घायलों को बोलने दें, अपराधियों को दंडित करने दें, बुरे कामों को रोकने वाली तकनीक को हस्तक्षेप करने दें, और समाज की अवधारणा में एक इंच सुधार करें, तभी हम एक ऐसी तकनीक की दिशा में मिलकर काम कर सकते हैं जिससे डर नहीं लगता भविष्य का उचित उपयोग.

# aifaner के आधिकारिक WeChat सार्वजनिक खाते का अनुसरण करने के लिए आपका स्वागत है: aifaner (WeChat ID: ifanr) आपको जल्द से जल्द अधिक रोमांचक सामग्री प्रदान की जाएगी।