आज एआई के क्षेत्र में एक महत्वपूर्ण खुला पत्र सामने आया।

350 AI अधिकारियों, जिनमें "ChatGPT के जनक" सैम अल्टमैन शामिल हैं, ने संयुक्त खुले पत्र पर हस्ताक्षर किए और चिंता व्यक्त की कि वर्तमान में विकसित AI तकनीक मनुष्यों के लिए एक संभावित खतरा पैदा कर सकती है।

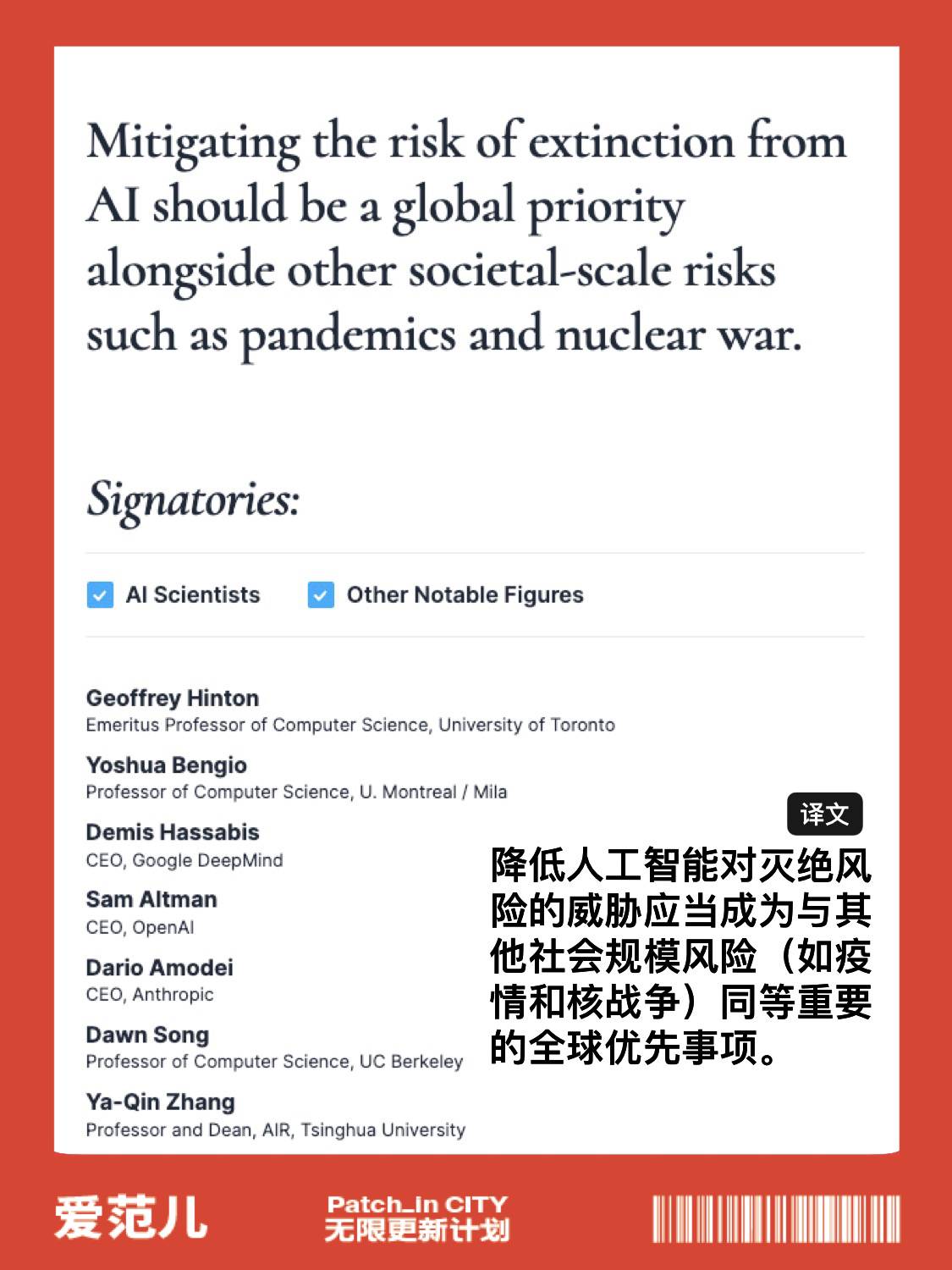

पत्र में केवल एक कथन था: महामारी और परमाणु युद्ध जैसे अन्य सामाजिक-स्तर के जोखिमों के साथ एआई के विलुप्त होने के जोखिम को कम करना एक वैश्विक प्राथमिकता होनी चाहिए।

खुले पत्र हस्ताक्षर में शामिल हों

https://www.safe.ai/statement-on-ai-risk

हस्ताक्षरकर्ताओं में तीन प्रमुख एआई कंपनी के अधिकारी शामिल हैं:

- OpenAI के सीईओ सैम अल्टमैन;

- गूगल डीपमाइंड के सीईओ डेमिस हासाबिस;

- एंथ्रोपिक के सीईओ डारियो अमोदेई;

इससे भी महत्वपूर्ण बात यह है कि सूची में कृत्रिम बुद्धि के दो "गॉडफादर", जेफ्री हिंटन और योशुआ बेंगियो हैं।

कृत्रिम बुद्धिमत्ता पर काम करने वाले 350 से अधिक अधिकारियों, शोधकर्ताओं और इंजीनियरों ने गैर-लाभकारी संगठन आर्टिफिशियल इंटेलिजेंस सेफ्टी सेंटर द्वारा जारी खुले पत्र पर हस्ताक्षर किए हैं, जिसमें तर्क दिया गया है कि कृत्रिम बुद्धिमत्ता से मानव विलुप्त होने का खतरा है और इसे महामारी से संबंधित माना जाना चाहिए। परमाणु युद्ध के बराबर जोखिम

समाज और रोजगार के लिए संभावित खतरे के बारे में चिंता बढ़ रही है, जो कि आर्टिफिशियल इंटेलिजेंस मॉडल जैसे चैटजीपीटी का विकास हो सकता है, एआई उद्योग के मजबूत विनियमन के लिए कई कॉल के साथ, जो अन्यथा समाज को अपूरणीय क्षति पहुंचाएगा।

एआई का बढ़ना जारी है, लेकिन प्रासंगिक पर्यवेक्षण और ऑडिटिंग के तरीकों को बरकरार नहीं रखा गया है, जिसका अर्थ है कि कोई भी एआई टूल्स की सुरक्षा और एआई टूल्स का उपयोग करने की प्रक्रिया की गारंटी नहीं दे सकता है।

पिछले हफ्ते, सैम ऑल्टमैन और दो अन्य OpenAI अधिकारियों ने प्रस्तावित किया कि AI के विकास की सुरक्षित निगरानी के लिए अंतर्राष्ट्रीय परमाणु ऊर्जा एजेंसी जैसे एक अंतरराष्ट्रीय संगठन की स्थापना की जानी चाहिए। उन्होंने प्रमुख अंतरराष्ट्रीय कृत्रिम बुद्धिमत्ता निर्माताओं से सहयोग करने का आह्वान किया और सरकार से नियंत्रण विनियमन को मजबूत करने के लिए कहा। अत्याधुनिक कृत्रिम बुद्धिमत्ता निर्माताओं की।

वास्तव में, मार्च की शुरुआत में, 6 महीने के लिए एआई शोध को रोकने के बारे में एक खुला पत्र पूरे इंटरनेट पर वायरल हो गया।

पत्र ने सभी एआई प्रयोगों को कम से कम 6 महीने के लिए जीपीटी -4 से अधिक उन्नत एआई मॉडल पर शोध को तुरंत निलंबित करने का आह्वान किया, ताकि इन भयानक कल्पनाओं को उनके पालने में मार दिया जा सके।

एआई प्रगति की गति आश्चर्यजनक है, लेकिन प्रासंगिक पर्यवेक्षण और ऑडिटिंग विधियों को बनाए नहीं रखा गया है, जिसका अर्थ है कि कोई भी एआई टूल्स की सुरक्षा और एआई टूल्स का उपयोग करने की प्रक्रिया की गारंटी नहीं दे सकता है।

संयुक्त पत्र को 2018 ट्यूरिंग अवार्ड विजेता योशुआ बेंगियो, मस्क, स्टीव वोज्नियाक, स्काइप सह-संस्थापक, Pinterest सह-संस्थापक, स्थिरता एआई सीईओ आदि सहित कई प्रसिद्ध हस्तियों से हस्ताक्षर समर्थन प्राप्त हुआ है, सह-हस्ताक्षरकर्ताओं की संख्या समय सीमा से पहले 1125 पर पहुंच गया है।

खुले पत्र का मूल पाठ इस प्रकार है:

आर्टिफिशियल इंटेलिजेंस में मनुष्यों के साथ प्रतिस्पर्धा करने की बुद्धि होती है, जो समाज और मनुष्यों के लिए गहरा जोखिम ला सकती है, जिसकी पुष्टि बड़ी संख्या में अध्ययनों [1] द्वारा की गई है और शीर्ष AI प्रयोगशालाओं द्वारा मान्यता प्राप्त है [2]। व्यापक रूप से मान्यता प्राप्त Asilomar AI सिद्धांतों के अनुसार, उन्नत AI पृथ्वी पर जीवन के इतिहास में एक बड़े परिवर्तन का प्रतिनिधित्व कर सकता है, और इस तरह की योजना बनाई जानी चाहिए और उचित ध्यान और संसाधनों के साथ प्रबंधित किया जाना चाहिए।

दुर्भाग्य से, हाल के महीनों में भी, एआई प्रयोगशालाओं को तेजी से शक्तिशाली डिजिटल दिमाग विकसित करने और तैनात करने के लिए एक भगोड़ा दौड़ में बंद कर दिया गया है, जिसे कोई भी समझ नहीं सकता है, भविष्यवाणी कर सकता है या विश्वसनीय रूप से नियंत्रित कर सकता है, भले ही वे निर्माता ऐसा नहीं कर सकते।

आधुनिक एआई सिस्टम के साथ अब आम कार्यों में मनुष्यों के साथ प्रतिस्पर्धा [3], हमें खुद से पूछना चाहिए:

- क्या हमें मशीनों को अपने सूचना चैनलों, प्रचार और झूठ फैलाने की अनुमति देनी चाहिए?

- क्या हमें संतोषजनक सहित सभी नौकरियों को स्वचालित करना चाहिए?

- क्या हमें गैर-मानवीय दिमाग विकसित करना चाहिए जो अंततः हमसे आगे निकल जाए और हमें बदल दे?

- क्या हमें नियंत्रण सभ्यता से बाहर होने का जोखिम उठाना चाहिए?

ये निर्णय अनिर्वाचित तकनीकी नेताओं द्वारा नहीं किए जाने चाहिए। केवल जब हम आश्वस्त हों कि एआई प्रणाली का प्रभाव सकारात्मक है और जोखिम प्रबंधनीय हैं, तभी हमें शक्तिशाली एआई सिस्टम विकसित करना चाहिए। यह विश्वास अच्छी तरह से स्थापित होना चाहिए और सिस्टम के संभावित प्रभाव से बढ़ता है। आर्टिफिशियल इंटेलिजेंस पर OpenAI के हालिया बयान में कहा गया है कि "कुछ बिंदु पर, भविष्य की प्रणालियों का प्रशिक्षण शुरू करने से पहले स्वतंत्र समीक्षा प्राप्त करना आवश्यक हो सकता है, और बनाने के लिए उपयोग की जाने वाली संगणना की विकास दर को सीमित करने के लिए अत्याधुनिक प्रयासों के लिए सहमत होना आवश्यक हो सकता है। नए मॉडल।" हम सहमत हैं। अब वह क्षण है।

इसलिए, हम GPT-4 से अधिक शक्तिशाली AI सिस्टम के प्रशिक्षण से कम से कम 6 महीने के लिए सभी AI प्रयोगशालाओं पर तत्काल रोक लगाने का आह्वान करते हैं। यह निलंबन सार्वजनिक और सत्यापन योग्य होना चाहिए, और इसमें सभी प्रमुख खिलाड़ी शामिल होने चाहिए। अगर इस तरह की रोक को जल्दी से लागू नहीं किया जा सकता है, तो सरकार को हस्तक्षेप करना चाहिए और रोक लगानी चाहिए।

एआई प्रयोगशालाओं और स्वतंत्र विशेषज्ञों को उन्नत एआई डिजाइन और विकास सुरक्षा प्रोटोकॉल के एक साझा सेट को विकसित करने और लागू करने के लिए एक साथ काम करने के लिए इस ठहराव का उपयोग करना चाहिए जिसकी स्वतंत्र बाहरी विशेषज्ञों द्वारा कठोर समीक्षा और निगरानी की जानी चाहिए।

इन प्रोटोकॉल को यह सुनिश्चित करना चाहिए कि उनका पालन करने वाली प्रणालियां उचित संदेह से परे सुरक्षित हैं [4]। इसका मतलब एआई के विकास को रोकना नहीं है, बल्कि हमेशा खतरनाक दौड़ से बड़े, अप्रत्याशित ब्लैक-बॉक्स मॉडल और उनकी उभरती क्षमताओं की ओर एक कदम पीछे हटना है।

एआई अनुसंधान और विकास को मौजूदा मजबूत, उन्नत प्रणालियों की सटीकता, सुरक्षा, व्याख्यात्मकता, पारदर्शिता, मजबूती, संरेखण, विश्वसनीयता और वफादारी में सुधार पर ध्यान देना चाहिए।

उसी समय, एआई डेवलपर्स को एआई गवर्नेंस सिस्टम के विकास में नाटकीय रूप से तेजी लाने के लिए नीति निर्माताओं के साथ काम करना चाहिए। इनमें कम से कम शामिल होना चाहिए:

- एआई को समर्पित एक नया, सक्षम नियामक निकाय;

- उच्च क्षमता वाले एआई सिस्टम और कंप्यूटिंग शक्ति के बड़े पूल का निरीक्षण और ट्रैकिंग;

- सिंथेटिक सामग्री से वास्तविक को अलग करने के लिए उत्पत्ति और वॉटरमार्किंग सिस्टम, मॉडल लीक पर नज़र रखना;

- मजबूत लेखापरीक्षा और प्रमाणन पारिस्थितिकी तंत्र, एआई के कारण होने वाली क्षति के लिए जवाबदेही;

- तकनीकी एआई सुरक्षा अनुसंधान के लिए पर्याप्त सार्वजनिक धन;

- बड़े पैमाने पर आर्थिक और राजनीतिक परिवर्तनों से निपटने वाली दिग्गज संस्था एआई का कारण बनेगी, विशेष रूप से लोकतंत्रों के लिए निहितार्थ।

एआई की मदद से मानवता एक समृद्ध भविष्य का आनंद ले सकती है। शक्तिशाली एआई सिस्टम बनाने में सफल होने के बाद, अब हम "एआई समर" का आनंद ले सकते हैं जिसमें हम इन सिस्टमों का स्पष्ट रूप से उपयोग करके सभी को लाभान्वित करने और समाज को अनुकूलन का मौका देने के लिए पुरस्कार प्राप्त कर सकते हैं।

समाज ने अन्य तकनीकों के सामने विराम का बटन दबा दिया है [5] जो समाज पर विनाशकारी प्रभाव डाल सकते हैं। यहाँ हम वही कर सकते हैं। आइए बिना तैयारी के गिरने की जल्दबाजी करने के बजाय एआई की लंबी गर्मी का आनंद लें।

#Aifaner के आधिकारिक WeChat सार्वजनिक खाते का अनुसरण करने के लिए आपका स्वागत है: Aifaner (WeChat ID: ifanr), जितनी जल्दी हो सके आपके लिए अधिक रोमांचक सामग्री प्रस्तुत की जाएगी।